Los electrodos interceptan señales cerebrales que, de no haber sido por el ictus, habrían ido a parar a los músculos de la lengua, la mandíbula, la laringe y la cara.

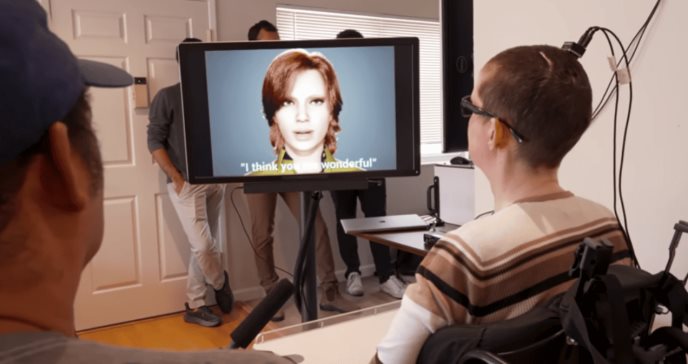

Una interfaz cerebro-ordenador (BCI) ha permitido a una mujer paralítica que perdió la capacidad de hablar tras sufrir un derrame cerebral comunicarse a través de un avatar digital. ?

Este logro de un equipo de investigadores de la Universidad de California en San Francisco (UCSF) y la Universidad de Berkeley es la primera vez que se sintetizan el habla y las expresiones faciales a partir de señales cerebrales.

"Nuestro objetivo al incorporar el habla audible a un avatar de acción real es permitir la plena encarnación de la comunicación verbal humana, que es mucho más que palabras", explicó en un vídeo publicado en YouTube el doctor Edward Chang, catedrático de cirugía neurológica de la UCSF, que lleva más de una década trabajando en esta tecnología.

"Para nosotros, se trata de un nuevo y emocionante hito que lleva nuestro dispositivo más allá de la prueba de concepto, y creemos que pronto se convertirá en una opción viable para las personas que sufren parálisis", pronostica Chang.

Más allá del texto en una pantalla

En un estudio anterior, el equipo de Chang demostró que es posible registrar la actividad neuronal de una persona paralizada que intenta hablar y traducir esa actividad en palabras y frases en forma de texto en la pantalla, como ya informó Medscape Medical News.

Su nuevo trabajo demuestra algo mucho más ambicioso: descodificar las señales cerebrales en la riqueza del habla junto con los movimientos que animan el rostro de una persona durante la conversación.

"En este nuevo estudio, nuestra traducción del intento de habla a texto alcanza unas 78 palabras por minuto. También demostramos que es posible traducir las señales neuronales no sólo a texto en una pantalla, sino también directamente a habla sintética audible, con movimientos faciales precisos en un avatar", afirma Chang.

Electrodos

El equipo implantó un rectángulo fino como el papel de 253 electrodos en la superficie del cerebro de la mujer, en zonas críticas para el habla. Los electrodos interceptan señales cerebrales que, de no haber sido por el ictus, habrían ido a parar a los músculos de la lengua, la mandíbula, la laringe y la cara. Un cable, conectado a un puerto fijado a su cabeza, conectaba los electrodos a un banco de ordenadores.

Los investigadores entrenaron y evaluaron modelos de aprendizaje profundo utilizando datos neuronales recogidos mientras la mujer intentaba pronunciar frases en silencio.

Durante semanas, repitió una y otra vez distintas frases de un vocabulario conversacional de 1024 palabras, hasta que el ordenador reconoció los patrones de actividad cerebral asociados a los sonidos. "Este dispositivo lee el plano de instrucciones que el cerebro da a los músculos del tracto vocal", explica Chang.

Para crear la voz del avatar, el equipo desarrolló un algoritmo para sintetizar el habla y utilizó una grabación de la voz de la mujer antes de la lesión para que el avatar sonara como ella. Para crear el avatar -esencialmente una animación digital del rostro de la mujer-, el equipo utilizó un sistema de software que simula y anima los movimientos musculares de la cara.

Procesos de aprendizaje personalizados

Crearon procesos personalizados de aprendizaje automático para que el software se adaptara a las señales que enviaba el cerebro de la mujer mientras intentaba hablar y las convirtiera en los movimientos de la cara del avatar, haciendo que la mandíbula se abriera y cerrara, los labios sobresalieran y se fruncieran y la lengua subiera y bajara, así como los movimientos faciales de felicidad, tristeza y sorpresa.

Esta investigación introduce un "enfoque multimodal de habla-neuroprótesis que promete devolver la comunicación plena y corporal a las personas con parálisis grave", escriben los investigadores en su artículo.

Afirman que el siguiente paso es crear una versión inalámbrica que no requiera que el usuario esté físicamente conectado a la BCI. "Dar a las personas [paralizadas] la capacidad de controlar libremente sus propios ordenadores y teléfonos con esta tecnología tendría profundos efectos en su independencia e interacciones sociales", concluyó en un comunicado de prensa el coautor Dr. David Moses profesor adjunto de cirugía neurológica de la UCSF.

Fuente consultada aquí.